Sigmoid注意力一样强,苹果开始重新审视注意力机制

Sigmoid注意力一样强,苹果开始重新审视注意力机制注意力是 Transformer 架构的关键部分,负责将每个序列元素转换为值的加权和。将查询与所有键进行点积,然后通过 softmax 函数归一化,会得到每个键对应的注意力权重。

注意力是 Transformer 架构的关键部分,负责将每个序列元素转换为值的加权和。将查询与所有键进行点积,然后通过 softmax 函数归一化,会得到每个键对应的注意力权重。

Transformer 在深度学习领域取得巨大成功的关键是注意力机制。注意力机制让基于 Transformer 的模型关注与输入序列相关的部分,实现了更好的上下文理解。然而,注意力机制的缺点是计算开销大,会随输入规模而二次增长,Transformer 也因此难以处理非常长的文本。

Jamba是第一个基于 Mamba 架构的生产级模型。Mamba 是由卡内基梅隆大学和普林斯顿大学的研究人员提出的新架构,被视为 Transformer 架构的有力挑战者。

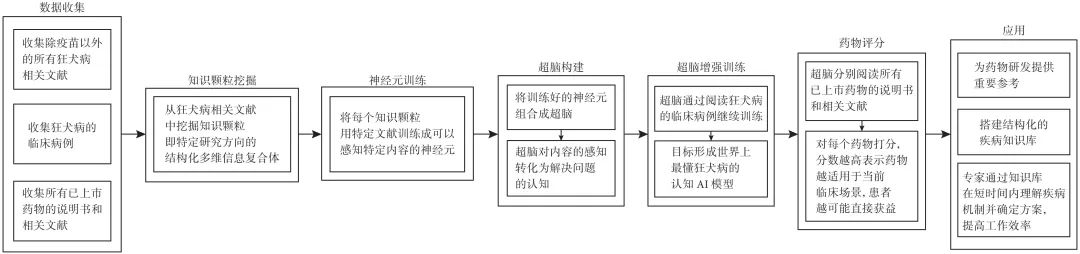

在当今数字化时代,人工智能(artificial intelligence,AI)技术迅猛发展,尤其是生成式技术,如ChatGPT(chat generative pre-trained transformer),对人类生活的影响日益深远。

过去几年间,Transformer 架构已经取得了巨大的成功,同时其也衍生出了大量变体,比如擅长处理视觉任务的 Vision Transformer(ViT)。本文要介绍的 Body Transformer(BoT) 则是非常适合机器人策略学习的 Transformer 变体。

一年前,谷歌最后一位 Transformer 论文作者 Llion Jones 离职创业,与前谷歌研究人员 David Ha共同创立人工智能公司 Sakana AI。Sakana AI 声称将创建一种基于自然启发智能的新型基础模型! 现在,Sakana AI 交上了自己的答卷。

Mamba 架构的大模型又一次向 Transformer 发起了挑战

2017 年,谷歌在论文《Attention is all you need》中提出了 Transformer,成为了深度学习领域的重大突破。该论文的引用数已经将近 13 万,后来的 GPT 家族所有模型也都是基于 Transformer 架构,可见其影响之广。 作为一种神经网络架构,Transformer 在从文本到视觉的多样任务中广受欢迎,尤其是在当前火热的 AI 聊天机器人领域。

七年前,论文《Attention is all you need》提出了 transformer 架构,颠覆了整个深度学习领域。

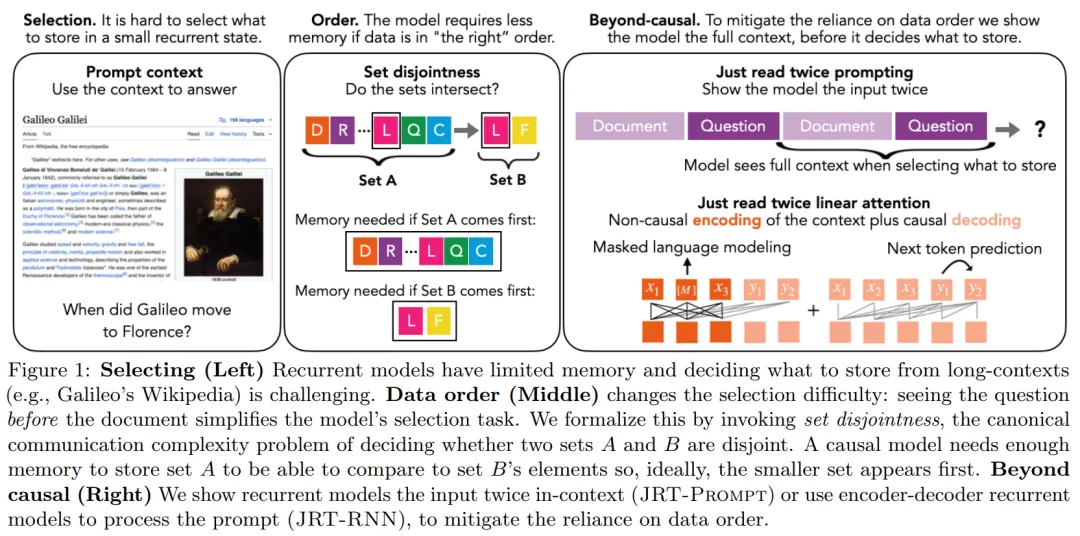

在当前 AI 领域,大语言模型采用的主流架构是 Transformer。不过,随着 RWKV、Mamba 等架构的陆续问世,出现了一个很明显的趋势:在语言建模困惑度方面与 Transformer 较量的循环大语言模型正在快速进入人们的视线。